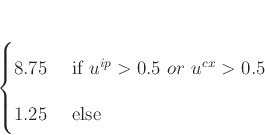

カオスニューラルネットワークを多層化したモデルとして, Figure 6.1のように

表される江本らによって提唱されたモデルがある。[6]

このモデルは, 入力層, 海馬モジュール, 連合野モジュールの3層からなるモデルであり,

以下の現象を発現可能としたものである。

- 逐次記憶

- メタ記憶

- 自由想起性

- 中期記憶による長期記憶の形成

- H.M.の臨床例に対応する現象

- エピソード記憶

- 意味記憶

図 6.1:

Network structure of model modeled by Emoto etc.

|

![\includegraphics[height = 10.0cm]{image1.eps}](img65.png) |

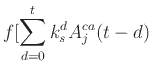

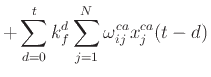

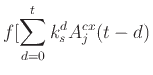

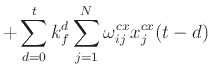

このモデルの海馬モジュールのニューロンの状態は次の式で与えられる。

また, このモデルの連合野モジュールのニューロンの状態は次の式で与えられる。

,

,  ,

,  はそれぞれ, 海馬モジュール, 連合野モジュール, 入力層を示すインデックスである。

はそれぞれ, 海馬モジュール, 連合野モジュール, 入力層を示すインデックスである。

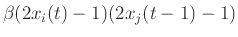

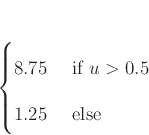

このモデルでは式(6.7), 式(6.8)の条件を共に満たすとき, 式(6.9)の式に基づいて学習を行う。

similarity |

|

|

(19) |

similarity |

|

similarity |

(20) |

|

|

|

(21) |

| |

|

|

|

| similarity |

|

|

(22) |

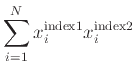

素子数

素子数

学習定数

学習定数

Deguchi Lab.

2017年3月6日

![$\displaystyle - \alpha \sum_{d=0}^t k_r^d x_i^{ca} (t - d) - \theta]$](img69.png)

![$\displaystyle - \alpha \sum_{d=0}^t k_r^d x_i^{cx} (t - d) - \theta]$](img77.png)